¿Qué Calidad Predictiva tiene el Modelo?

Diagnosis de Modelos con Respuesta Binaria

Evaluando Modelos con Respuesta Binaria

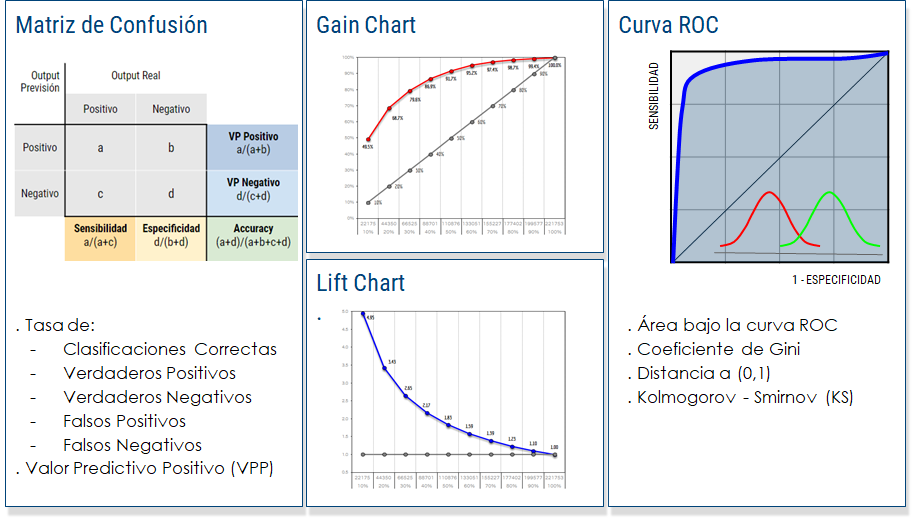

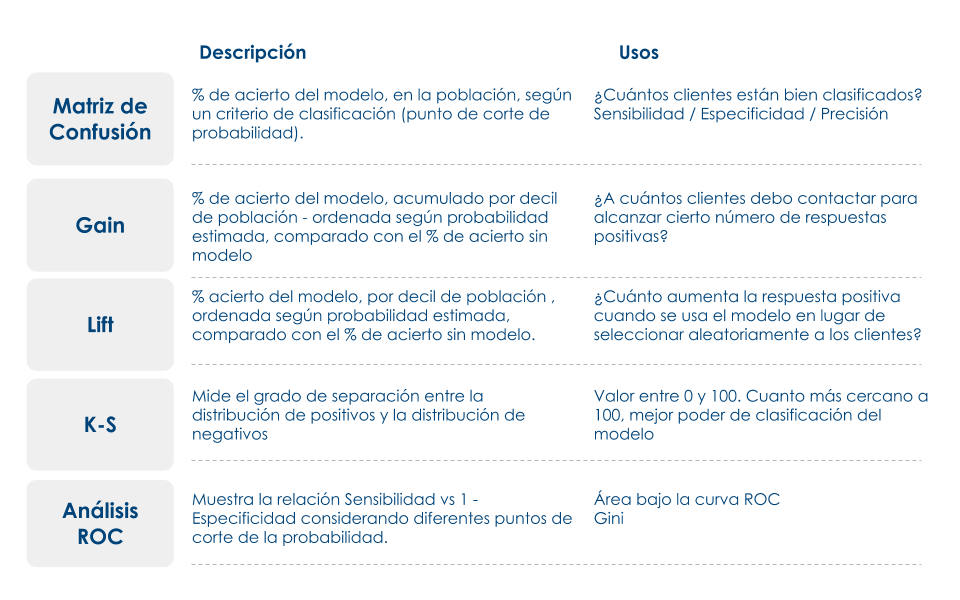

Figure 1: Algunos Indicadores para Diagnosticar la Calidad de la Clasificación

Calidad de la Clasificación

En los problemas de clasificación tenemos la variable objetivo que son las clases o etiquetas que debemos predecir y una serie de variables que son los predictores. Es decir, usando los predictores obtenemos una etiqueta. Nos podemos encontrar con problemas de clasificación binaria (dos clases) o múltiple (más de dos clases).

Para simplificar nos centraremos en la clasificación binaria, pero lo podemos trasladar a los problemas de clasificación múltiple.

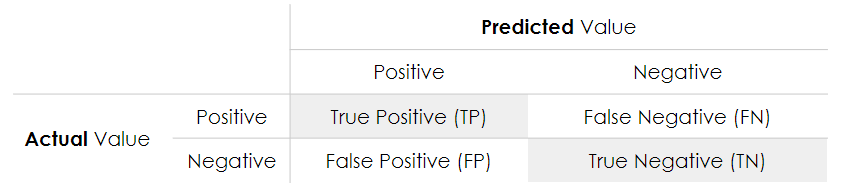

Matriz de Confusión

La confusion matrix o matriz de confusión muestra el número de predicciones correctas e incorrectas hechas por el modelo de clasificación en comparación con los resultados reales en los datos. La matriz de confusión es una matriz \(n \times n\), dónde \(n\) es el número de clases. La siguiente tabla muestra una matriz de confusión de \(2x2\) para dos clases (positiva y negativa).

Figure 2: Matriz de Confusión

- Accuracy: la proporción del número total de predicciones correctas.

\[ACC = \frac{TP+TN}{TP+TN+FP+FN}\]

- Positive Predictive Value or Precision: la proporción de casos positivos que fueron identificados correctamente.

\[PPV = \frac{TP}{TP+FP}\]

- Negative Predictive Value: la proporción de casos negativos que fueron identificados correctamente.

\[ NPV = \frac{TN}{TN+FN} \]

- Sensitivity or Recall: la proporción de casos positivos reales que están correctamente identificados.

\[TPR = \frac{TP}{TP+FN}\]

- Specificity: la proporción de casos negativos reales que están correctamente identificados.

\[TNR = \frac{TN}{TN+FP}\]

Log-Loss

La log-loss o pérdida logarítmica entra en los detalles más finos de un clasificador. En particular, si la salida bruta del clasificador es una probabilidad numérica en lugar de una etiqueta de clase de \(0\) o \(1\), se puede usar la log-loss. La probabilidad se puede entender como un indicador de confianza. Si la etiqueta es \(0\) pero el clasificador cree que pertenece a la clase \(1\) con probabilidad de \(0.51\). Aunque el clasificador estaría cometiendo un error de clasificación, el error se comente por poco, ya que la probabilidad está muy cerca del punto de corte de \(0.5\). La log-loss es una medición de precisión que incorpora esta idea de confianza probabilística.

La log-loss para un clasificador binario es

\[LogLoss = - \frac{1}{n} \sum_{i=1}^{n} y_i \log p_i + (1-y_i) \log (1-p_i)\]

donde \(n\) es el número de registros, \(y_i\) es la etiqueta de la muestra \(i\), y \(p_i\) es la probabilidad del obtenida en el modelo.

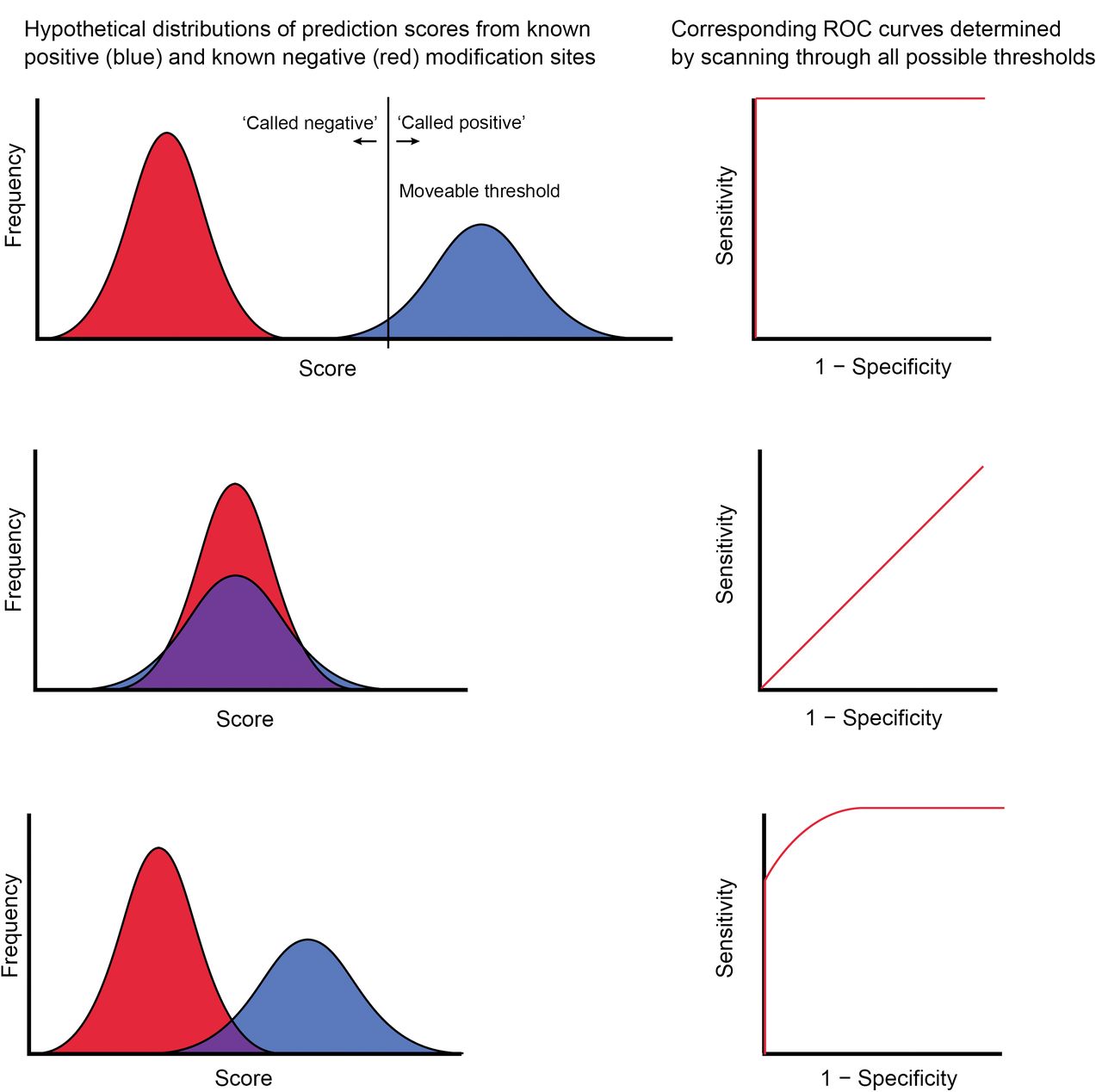

Curva ROC

Para los modelos de clasificación obtenidos a partir de una probabilidad se suelen usar las curvas ROC. Una curva ROC (acrónimo de Receiver Operating Characteristic, o Característica Operativa del Receptor) es una representación gráfica de la sensitivity (TPR) frente a la specificity (TNR) para un sistema clasificador binario según se varía el umbral de discriminación.

La curva ROC se puede usar para generar estadísticos que resumen el rendimiento (o la efectividad, en su más amplio sentido) del clasificador. A continuación se proporcionan algunos:

- El punto de inserción de la curva ROC con la línea convexa a la línea de discriminación.

- El área entre la curva ROC y la línea de convexo-paralela discriminación.

- El área bajo la curva ROC, llamada comúnmente AUC (area under curve).

El indicador más utilizado en muchos contextos es el área bajo la curva ROC o AUC. Este índice se puede interpretar como la probabilidad de que un clasificador ordenará o puntuará una instancia positiva elegida aleatoriamente más alta que una negativa.

En la figura abajo se muestran tres ejemplos de curvas ROC. La gráfica de la izquierda es la curva de un modelo perfecto, la del medio es la de un caso real con una \(AUC = 0.8\) y la de la derecha es la gráfico de un modelo no informativo.

Figure 3: Interpretando la Curva ROC

Ganancia y elevación (Gain and Lift Charts)

La ganancia y la elevación son medida de la efectividad de un modelo de clasificación calculado como la relación entre los resultados obtenidos con y sin el modelo. Los gráficos de ganancia y elevación son ayudas visuales para evaluar el rendimiento de los modelos de clasificación. Sin embargo, en contraste con la matriz de confusión que evalúa los modelos en toda la población, los gráficos de ganancia o elevación evalúan el modelo en una porción de la población.

Para crear estos gráficos es necesario crear un ranking basado en la creabilidad de la clasificación (previsión) hecha por el modelo.

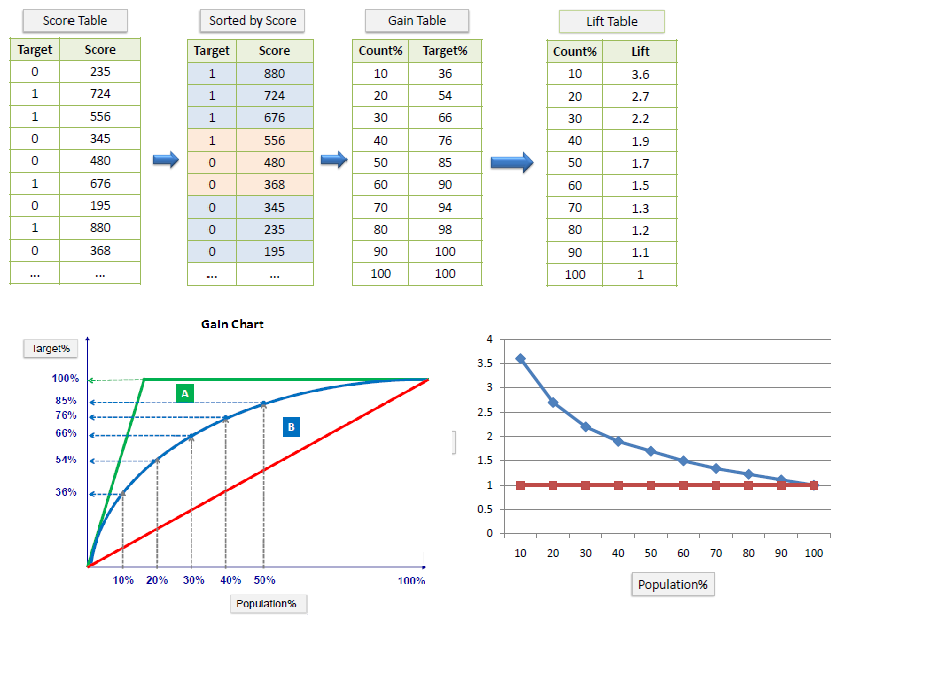

En la figura4 se muestra un ejemplo de como obtener los puntos de las curvas de ganancia y elevación, y sus correspondientes gráficos.

Figure 4: Cálculo de las curvas Lift y Gain

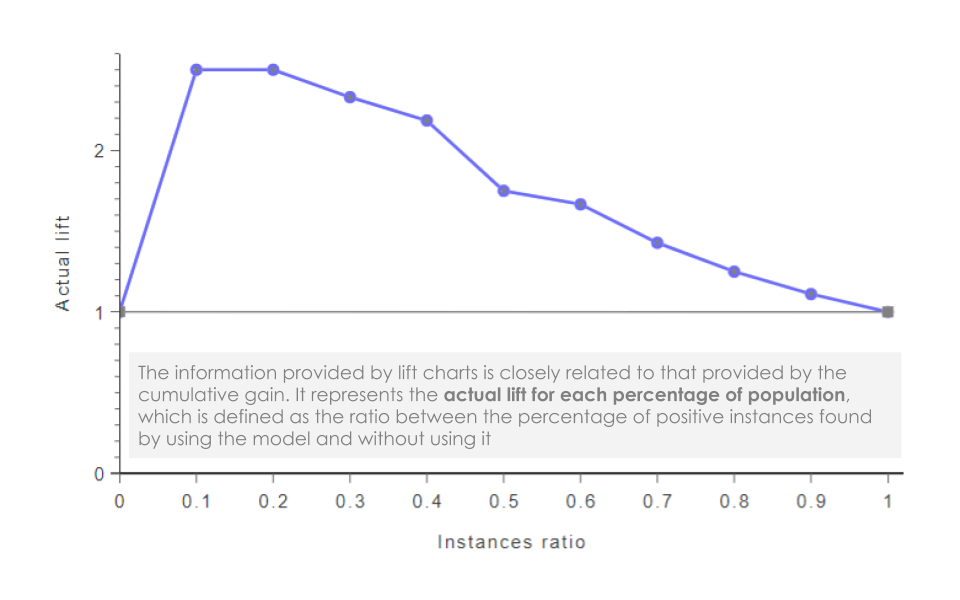

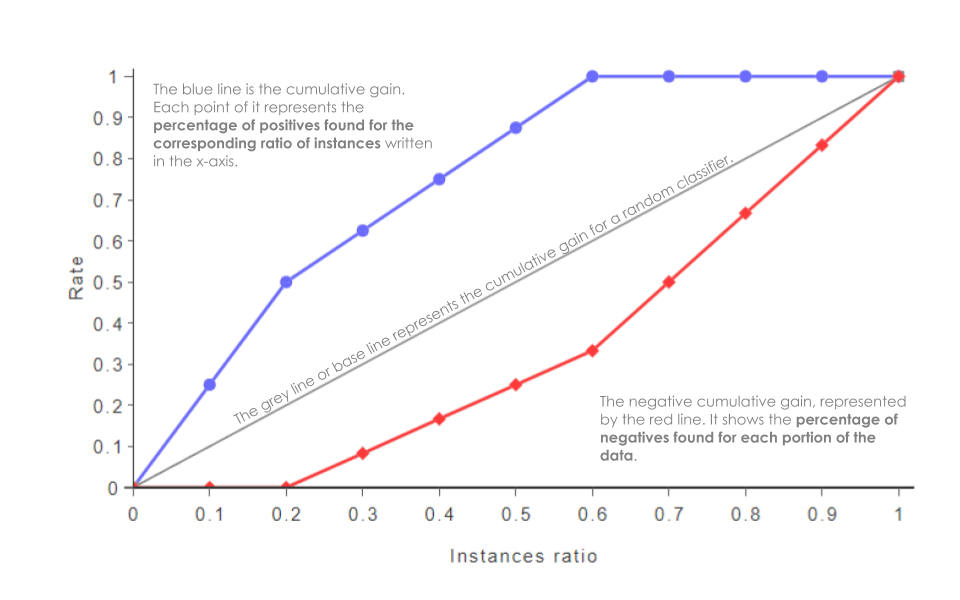

Igual que las curvas ROC, se busca el mayor AUC en las curvas de ganancia. Mientras que para los gráficos de elevación el modelo perfecto es el que la diferencia entre la línea azul y roja es nula. En otras palabras queremos una AUC mínima del gráfico de elevación. En las figuras 5 y figuras 6 se muestra la forma de interpretar las curvas de Lift y Gain acumulado, respectivamente.

Figure 5: Interpretación del Lift plot

Figure 6: Interpretación del Cumulative Gain plot

Figure 7: Resumen de Métricas de Calidad de la Clasificación

Medidas de desigualdad

Coeficiente de Gini

El coeficiente de Gini es una medida de la desigualdad ideada por el estadístico italiano Corrado Gini. El coeficiente de Gini es un número entre \(0\) y \(1\), en donde \(0\) se corresponde con la perfecta igualdad y donde el valor \(1\) se corresponde con la perfecta desigualdad.

El coeficiente de Gini se calcula como una proporción de las áreas en el diagrama de la curva de Lorenz. De forma resumida, la Curva de Lorenz es una gráfica de concentración acumulada de la distribución superpuesta a la curva de la distribución de frecuencias de los individuos, y su expresión en porcentajes es el índice de Gini. El coeficiente de Gini puede obtener mediante la siguiente fórmula:

\[G = \left| 1-\sum_{k=1}^{n-1} (X_{k+1}-X_k)(Y_{k+1}+Y_k) \right|\]

donde \(X\) es la proporción acumulada de la variable población, \(Y\) es la proporción acumulada de la variable a estudiar la desigualdad y \(n\) es el número de la población.

Índice de entropía

El índice de entropía generalizado se ha propuesto como una medida de la desigualdad en una población. Se deriva de la teoría de la información como una medida de redundancia en los datos. En la teoría de la información, una medida de redundancia puede interpretarse como no aleatoriedad o compresión de datos; por lo tanto, esta interpretación también se aplica a este índice.

La fórmula de la entropía general para un valor real \(\alpha\) es:

\[GE(\alpha) = \begin{cases} \frac{1}{n\alpha (\alpha -1)} \sum_{i=1}^{n} \left(\left( \frac{y_i}{\bar{y}} \right) ^{\alpha} -1\right), &\quad \alpha\neq0,1 ,\\ \frac{1}{n} \sum_{i=1}^{n} \frac{y_i}{\bar{y}} \ln \frac{y_i}{\bar{y}} &\quad \alpha = 1 ,\\ -\frac{1}{n} \sum_{i=1}^{n} \ln \frac{y_i}{\bar{y}} &\quad \alpha = 0 .\\ \end{cases}\]

donde \(n\) el número de muestras y \(y\) es la medida de desigualdad.